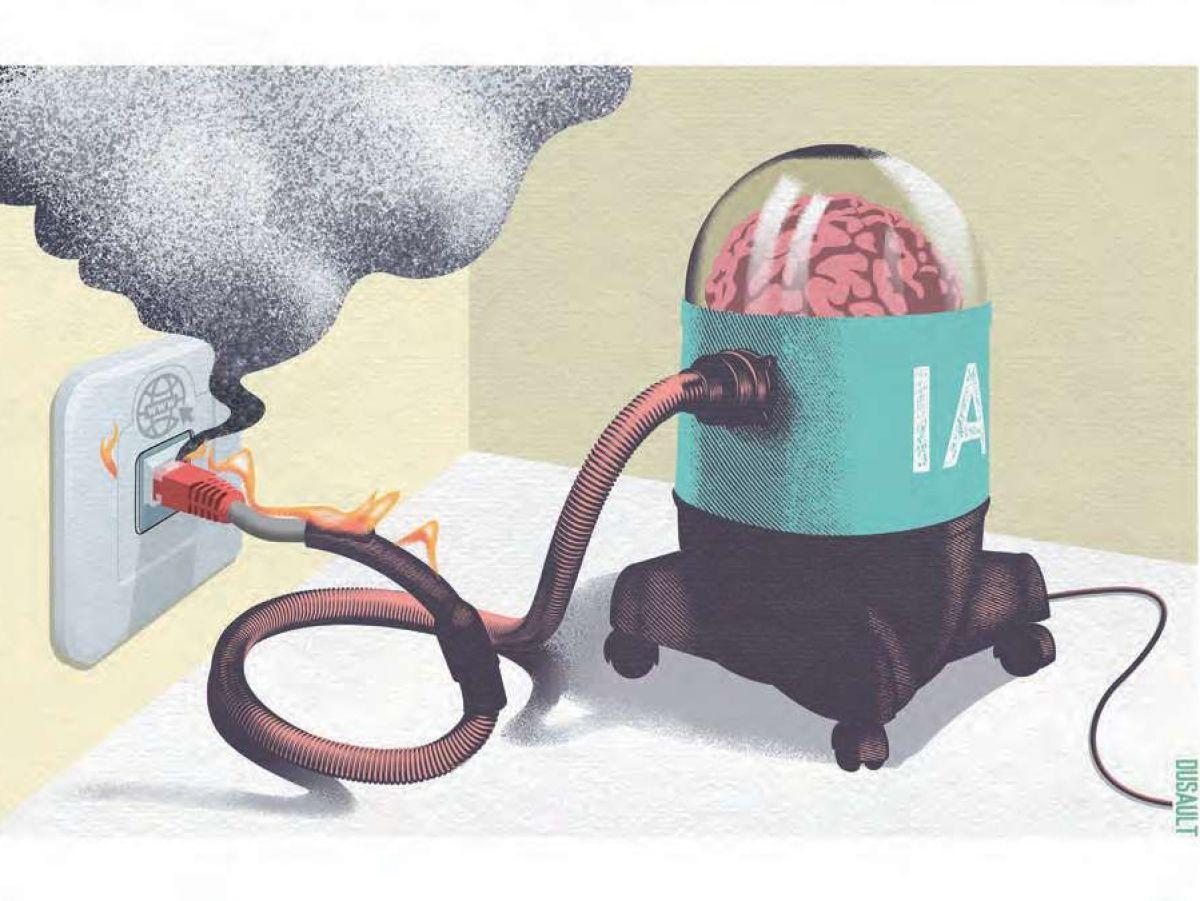

Africa-Press – Congo Brazzaville. ‘est quasiment un cri d’alarme. Le 1er avril, la Fondation Wikimédia, l’organisme à but non lucratif qui promeut et développe les projets collaboratifs tels Wikipédia, WikiCommons ou Wiktionnaire, révélait en ligne combien l’industrie de l’intelligence artificielle perturbait le fonctionnement de ses sites.

Les textes de Wikipédia et les 144 millions de fichiers multimédias de Wiki-Commons, en accès libre, sont en effet une manne de données pour les algorithmes d’OpenAI, Meta, Anthropic et consorts, qui envoient des logiciels automatisés, les web crawlers, collecter tous ces contenus.

Résultat: « Depuis janvier 2024, la bande passante utilisée pour le téléchargement de contenus multimédias a augmenté de 50 % « , déclare la fondation. Or, si les contenus sont gratuits, ils impliquent une maintenance et une mise à niveau technique permanentes. « La fondation Wikimédia dispose de ses propres datacenters [centre de données] à travers le monde pour ne pas avoir à recourir à des prestataires tiers, et entretient sa propre infrastructure Web, conçue pour que les utilisateurs accèdent aux contenus avec une faible latence, détaille Elena Simperl, professeure d’informatique au King’s College de Londres (Royaume-Uni). Cela implique des frais en matière de gestion de serveurs, d’énergie, mais aussi de rémunération des équipes chargées de veiller au fonctionnement et à la sécurité de ces infrastructures. »

L’équivalent d’une attaque par déni de service

Lors des pics de trafic dus à des actualités fortes, par exemple, l’équipe ingénierie et fiabilité du site laisse des contenus prioritaires en « cache », optimise les connexions aux serveurs en fonction des zones géographiques des requêtes. Les web crawlers s’ajoutent à ces pics « humains » sans « autres objectifs qu’extraire des données, poursuit Elena Simperl. Ils naviguent de manière autonome sur les sites en suivant les liens pour accéder au plus grand nombre possible de pages. Cela génère un fort trafic, de manière irrégulière, qui peut devenir envahissant et lourd financièrement. »

Le problème est plus général, comme en ont témoigné nombre d’utilisateurs du Web, notamment les communautés open source pour qui l’impact financier est difficile à tenir. Ingénieur chez Mozilla, Dennis Schubert relevait en décembre 2024 que 70 % des requêtes sur son serveur Diaspora (un réseau social décentralisé) venaient de web crawlers, ceux d’OpenAI seuls comptant pour 24,6 %. « C’est littéralement une attaque par déni de service de l’ensemble d’Internet « , estime-t-il.

En mars, un billet de blog désemparé du développeur Drew DeVault évoquait des « dizaines de petites pannes par semaine » sur sa plateforme SourceHut. Le 19 mars, sur la plateforme GitLab, la communauté open source KDE a été inaccessible à cause d’un web crawler du géant chinois Alibaba.

Pour amoindrir le choc, la Fondation Wikimédia propose une version de Wikipédia (anglophone et francophone) structurée comme un jeu d’entraînement pour IA: 113,58 gigaoctets sont ainsi mis à disposition des web crawlers sur la plateforme Kaggle. Une manière de détourner les bots du site lui-même.

D’autres réactions sont plus radicales. Comme le blocage de tous les bots, sachant que cela peut être dommageable pour Internet, ou le fait d’imposer une « preuve de travail » aux connexions qui arrivent sur un serveur, c’est-à-dire un calcul permettant de distinguer les demandes légitimes des autres requêtes. Au risque de ralentir l’accès des premières.

Un développeur s’est quant à lui inspiré des techniques anti-spam: il attire les web crawlers vers des pages remplies de faux contenus et de charabia, d’où l’absence de liens qui les empêche durant un temps de sortir. Le prestataire de services Internet Cloudflare propose à ses clients une option du même genre, quoique moins agressive, AI Labyrinth. Il s’agit de pages elles-mêmes générées par IA, sans inexactitudes mais inutiles car sans rapport avec le site protégé. Les bots y gaspillent leur temps et leurs ressources, tandis que les internautes et les web crawlers légitimes n’y ont, eux, pas accès.

Web crawler (robot d’exploration du Web)

Ce terme désigne un programme informatique qui parcourt automatiquement le Web. L’usage le plus connu est destiné aux moteurs de recherche et consiste à indexer des pages Web en suivant les liens qui s’y trouvent (robot d’indexation). D’autres web crawlers aident à la maintenance d’Internet (traquer les liens cassés) ou à l’archivage de sites. Il existe aussi des usages malveillants (collecte de courriels pour du spam, achat massif de billets de spectacle pour les revendre). Les robots de l’IA téléchargent tout ce qu’ils trouvent sur le Web: textes, images, sons, discussions, code informatique, revenant plusieurs fois sur les mêmes pages pour mettre à jour leurs données. Celles-ci alimentent l’entraînement des algorithmes d’apprentissage.

Pour plus d’informations et d’analyses sur la Congo Brazzaville, suivez Africa-Press