Africa-Press – Senegal. Cet article est extrait du mensuel Sciences et Avenir – La Recherche n°923, daté janvier 2024.

Scanner le Web. La pratique n’est pas nouvelle, elle consiste à explorer le Web avec un logiciel (un “Web crawler”) à des fins d’indexation, comme le font les moteurs de recherche, ou d’archivage. Les éditeurs de sites Internet ne s’en formalisaient pas plus que cela, mais à l’automne 2022, l’apparition de ChatGPT a agi comme un électrochoc.

L’agent conversationnel d’OpenAI fonctionne grâce à une famille de modèles de langage (GPT) entraînée sur de gigantesques volumes de contenus récupérés en ligne. Forums, blogs, articles, pages Wikipédia, sites de médias, bases publiques de codes informatiques, le “Web crawler” d’OpenAI GPTBot prend tout ce qu’il trouve. Google pour son modèle LaMDA (moteur du chatbot Bard) ou Meta pour LLaMA font la même chose. Autrement dit, le “scan” du Web a conduit à la production d’une technologie capable de créer elle-même du contenu.

Sans oublier que ChatGPT existe en version payante et est intégré dans le moteur Bing de Microsoft. Tout cela en se servant des données des autres sans avoir demandé, et encore moins payé. Même chose pour les intelligences artificielles (IA) qui génèrent des images à partir de descriptions en langage naturel (Dall-E 2, Midjourney).

Et ce n’est qu’un début, souligne Olivier Martinez, fondateur de 255hex.ai et consultant en intégration d’IA génératives en entreprise: “Pendant des années, on a fait des entraînements séparés pour le texte, l’image, le son. Or, les modèles deviennent multimodaux (production simultanée de données de natures différentes, ndlr), donc l’entraînement devient aussi multimodal. C’est la suite logique.”

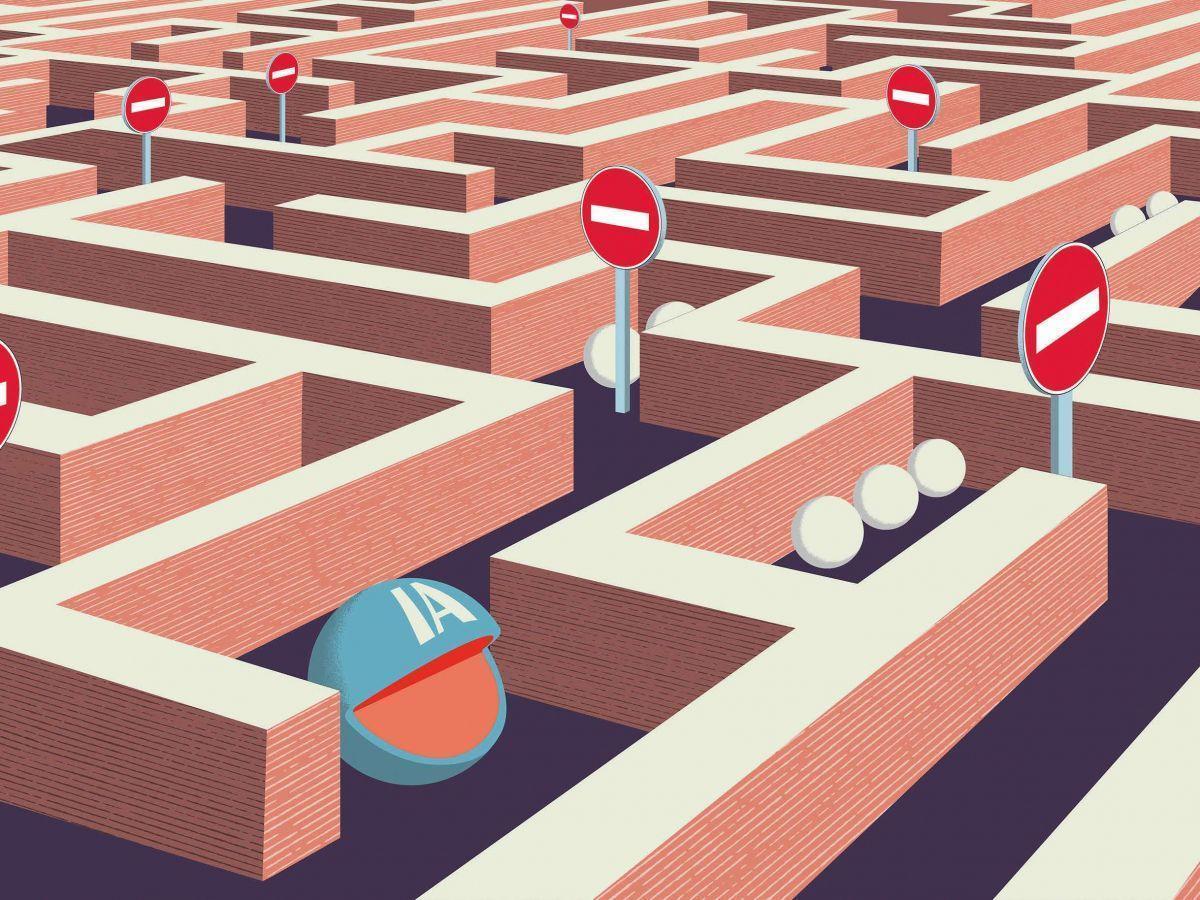

Des médias bloquent le robot “crawler” d’OpenAI

Depuis avril, les plateformes de forums Reddit et Stack Over-Flow font payer l’accès à leurs données à travers leur interface de programmation. Puis des médias (CNN, The New York Times, Reuters, Radio France, TF1info.fr, Mediapart, Libération, Le Figaro…) se sont mis à bloquer le robot “crawler” d’OpenAI sur leurs sites. Ce blocage consiste à insérer une instruction dans un fichier appelé robot.txt, qui indique à tout type de robot venant sur le site ce qu’il a le droit ou non de faire. OpenAI et Google ont eux-mêmes indiqué comment bloquer ainsi leurs bots respectifs.

Mais, techniquement, rien n’empêche de passer outre. De plus, la méthode concerne des bots nommément cités, dans le cas présent GPTBot et ChatGPT-user pour OpenAI et Google Extended et VertexAI chez Google. “Rien ne dit qu’OpenAI n’en a pas d’autres ou ne passe pas par des prestataires”, note encore Olivier Martinez. La méthode est surtout un signal envoyé par les éditeurs qu’ils veulent négocier un cadre légal pour l’usage de leurs données, contrepartie financière à la clef.

Mais ces péripéties relèvent d’un enjeu plus global. “Les performances d’un modèle d’apprentissage automatique sont liées, entre autres choses, à la quantité de données vues lors de son entraînement, mais on ne peut pas réutiliser encore et encore les mêmes données car cela dégrade ces performances. Donc pour les améliorer, l’une des quelques solutions connues consiste à l’entraîner sur de nouvelles données “, explique Pablo Villalobos, expert du groupe de recherche en intelligence artificielle Epoch, coauteur d’un article prévoyant une pénurie de données dites de qualité pour les modèles de langage d’ici à 2026.

Une information de qualité difficile à obtenir

Cette catégorie des données de qualité désigne des contenus ayant passé certains filtres: textes professionnels, articles sourcés ou revus par les pairs, littérature scientifique… Maintenant que les technologies savent parfaitement imiter le langage naturel, ces données deviennent cruciales pour que Bard ou ChatGPT livrent des réponses factuellement exactes. Or, leur accès ne va pas de soi. “GitHub est la plus vaste plate-forme publique de codes informatiques et les modèles actuels l’utilisent déjà, cite en exemple Pablo Villalobos, donc pour en avoir plus, il faudrait se tourner vers des données privées ou d’origine obscure, comme des bases internes d’entreprises privées.” Après le défi technique, la bataille pour les données d’entraînement est en train de se muer en bataille légale.

“Entraînement”

Les algorithmes d’apprentissage automatique peuvent fournir un résultat (reconnaître un visage, un son, traduire, générer du texte, prendre une décision) parce qu’ils ont été exposés au préalable à des données dont ils ont tiré des régularités statistiques. Ce sont les données d’entraînement, un corpus cohérent en lien avec la tâche que l’algorithme doit réaliser (par exemple, des CV de candidats embauchés pour un algorithme de recrutement). Une deuxième phase, la validation, utilise des données du même type mais qui n’ont pas été vues lors de l’entraînement. Elle sert à voir comment l’algorithme se comporte et à mieux le régler. Souvent, les données d’apprentissage et de validation sont issues d’un même corpus divisé en deux. La phase de test évalue les performances de l’algorithme finalisé sur des données entièrement nouvelles (validation et test se confondent parfois).

Pour plus d’informations et d’analyses sur la Senegal, suivez Africa-Press