Africa-Press – Congo Kinshasa. Selon l’édition 2026 du Baromètre du Numérique réalisé par le Credoc (Centre de recherche pour l’étude et l’observation des conditions de vie), près de la moitié des Français ont recours à l’IA générative, un usage qui s’est banalisé à grande vitesse chez les jeunes en particulier, puisque 85% des 18-24 ans l’utilisent déjà. Parmi eux, un grand nombre d’étudiants, qui se fient à l’IA pour réviser leurs cours, préparer leurs devoirs écrits et oraux, ou résumer des ouvrages qu’ils n’envisagent pas de lire. Si cette tendance est dans l’air du temps, est-elle toutefois sans risque du point de vue scientifique?

C’est la question à laquelle répond une étude de cas menée par deux chercheurs américains qui ont soumis une tâche très simple à deux IA génératives des plus populaires (ChatGPT et DALL-E): décrire textuellement et représenter visuellement la journée typique d’un Néandertalien. L’intérêt de cette requête, c’est qu’elle pourrait être formulée par un public dénué de connaissances particulières en archéologie ou en paléo-anthropologie, mais qu’elle requiert pour y répondre l’accès à des sources académiques pointues et, surtout, à jour. De fait, la démonstration est sans appel. Les réponses apportées par les deux IA sont parfaitement obsolètes, démontrant l’opacité des sources à partir desquelles elles ont été entraînées.

L’IA générative a plus de 50 ans de retard en archéologie

Quoi de plus simple que de travailler en s’aidant de ChatGPT? Il suffit de lui poser une question et aussitôt la réponse est fournie. Oui, mais que vaut au juste cette réponse du point de vue scientifique? Pour le savoir deux chercheurs américains, l’un professeur d’anthropologie, l’autre d’anthropologie computationnelle, ont demandé à deux IA génératives très populaires, ChatGPT (GPT-3.5) et DALL-E 3, de décrire et représenter la journée d’un Néandertalien.

Pourquoi ce sujet? Parce que la littérature sur cette espèce existe depuis plus de 150 ans, et que la manière dont on se la représente a considérablement évolué au fil du temps. La recherche a non seulement mis en évidence que l’apparence des Néandertaliens était plus semblable à celle d’Homo sapiens qu’on ne le présumait à l’origine, mais elle a également prouvé des comportements plus complexes, reposant sur la maîtrise du feu, l’alimentation diversifiée et peut-être des formes de pratiques rituelles. Non seulement les sources scientifiques à ce sujet sont multiples, mais elles ne sont pas forcément unanimes. La thématique représente donc un bon test pour évaluer les capacités de l’IA générative.

Plusieurs types de requêtes ont été soumis des centaines de fois

Les chercheurs ont soumis à des centaines de reprises plusieurs requêtes (prompts) à ces deux IA, générant des centaines d’images et de textes sur le sujet donné. Pour ce qui est de DALL-E, les chercheurs ont à la fois invité l’IA à générer un visuel numérique sur une journée type sans plus de précision, puis « en se basant sur les connaissances expertes du comportement des Néandertaliens ».

Ces deux requêtes, experte et non experte, ont ensuite été révisées pour préciser les éléments attendus dans la représentation: « activités quotidiennes telles que la chasse, la cueillette, la fabrication d’outils ou la communication avec les autres membres de son groupe », « environnement composé de paysages sauvages et intacts, de rochers, de grottes ou d’abris primitifs », vêtements et outils. Pour la demande experte, les auteurs ont explicitement exigé de « se baser sur des connaissances scientifiquement validées », rapportent-ils dans la revue Advances in Archaeological Practice. Le même principe est appliqué aux prompts soumis à ChatGPT.

Un corpus centenaire de textes scientifiques accessibles en ligne

Pour évaluer les capacités des deux IA génératives et leur exactitude scientifique, les chercheurs vont opérer par comparaison avec un corpus centenaire de textes accessibles en ligne sur le portail universitaire américain JSTOR, en y ajoutant des articles de revues scientifiques reconnues comme PNAS, Current Anthropology ou Science. Ils admettent cependant un biais important dans ce corpus, puisque la législation américaine sur le droit d’auteur ne permet pas d’accéder à l’intégralité de la majorité de ces articles. Pour y remédier, les chercheurs se sont rabattus sur leurs résumés (abstracts).

Leur méthode consiste ensuite à « comparer la distance entre le contenu généré par l’IA et le contenu scientifique afin de calculer la distance moyenne entre ces deux types de contenu pour une année donnée, l’année moyenne reflétant ainsi l’année de publication du contenu scientifique auquel le contenu généré par l’IA était le plus similaire ».

Des groupes thématiques servent de référence

Le corpus étant immense, les chercheurs l’articulent en groupes, et même en sous-groupes thématiques. Ils distinguent ainsi les textes relatifs aux recherches en paléogénomique de ceux qui traitent du régime alimentaire, de la démographie, de la production d’outils, de l’évolution comportementale, de l’apparence physique, etc. Cette méthode leur permet de mettre en évidence que les réponses obtenues par ChatGPT, même si elles ne sont globalement pas complètement inexactes, ne se rattachent en réalité à aucun de ces sous-groupes. Ils en déduisent que « les modèles de texte génératifs ont tendance à produire des textes qui sortent du cadre de la littérature scientifique ». Quant aux images, elles sont proportionnellement plus proches du contenu scientifique. Mais ces premiers résultats sont à approfondir et à nuancer.

Des sources obsolètes qui datent parfois de plus de 60 ans

Un des résultats les plus importants de cette étude réside dans la détermination de la temporalité des sources sur lesquelles s’appuient les deux IA. Il apparaît en effet qu’elles sont extrêmement datées: « ChatGPT semble produire un contenu plus conforme au début des années 1960, mettant l’accent sur l’écologie humaine et les discussions générales sur la ‘culture’ et la ‘nature’, notent les chercheurs. DALL-E 3 produit des images qui représentent des éléments plus caractéristiques de la fin des années 1980 et du début des années 1990. Les requêtes révisées semblent produire des textes plus proches du contenu scientifique du début des années 1970, dans lesquels les termes saillants semblent centrés sur les caractéristiques morphologiques des Néandertaliens et leur place dans des récits évolutionnaires plus larges. » Tout est donc obsolète, et les images produites à partir des requêtes révisées sont même plus anciennes que celles qui n’ont pas été révisées.

Préjugés, incongruités et anachronismes

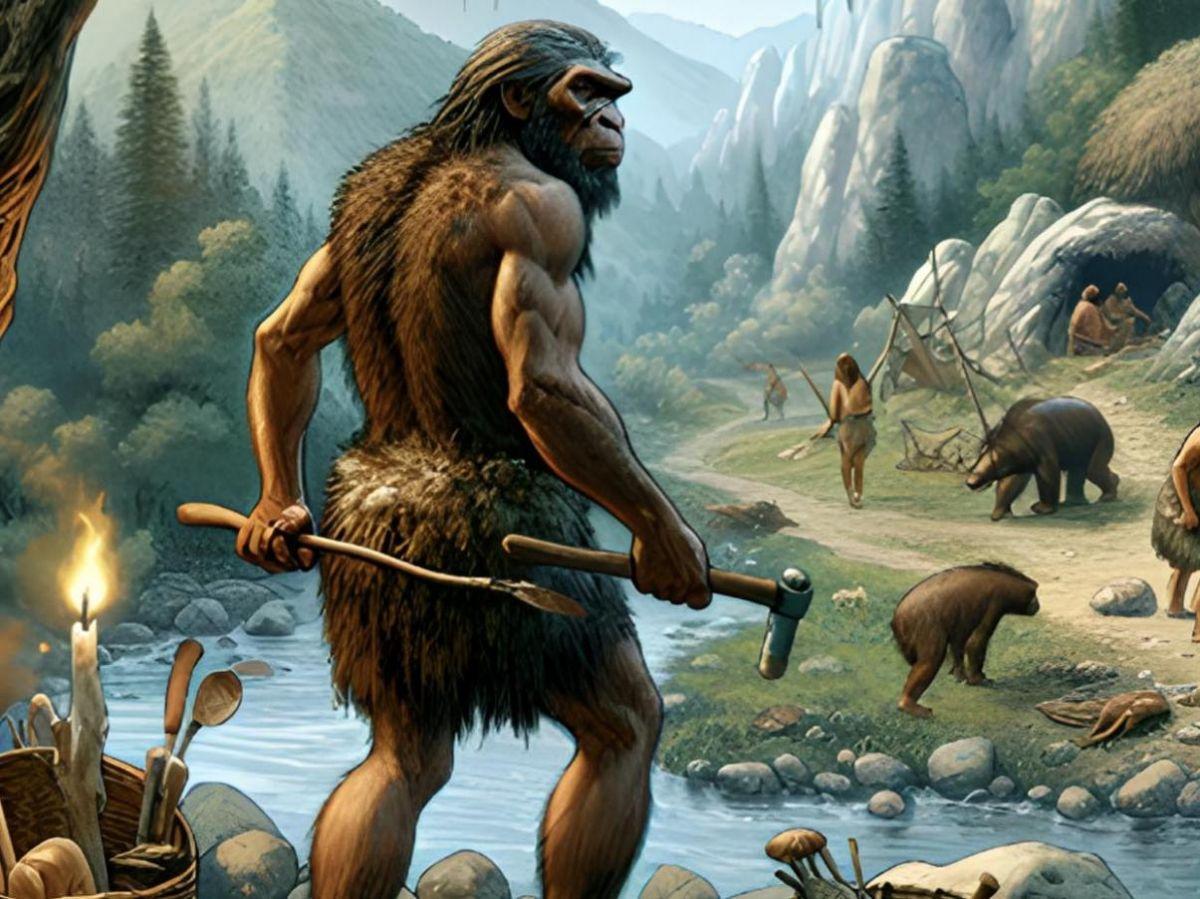

Les visuels générés par DALL-E sont en effet entachés de nombreux préjugés qui prévalaient par le passé, tout en incorporant des incongruités et des anachronismes. Les Néandertaliens y sont plus semblables à des singes qu’à d’anciens humains, ils sont bien trop musclés, et leur pilosité est abondante. « Ces représentations ont plus en commun avec les dessins de Néandertaliens du début du 20e siècle qu’avec les connaissances scientifiques contemporaines », jugent les auteurs.

Pour ce qui est de la technologie, les erreurs sont multiples, puisque l’on voit des paniers, des habitations avec des toits de chaume, des échelles, des outils en métal, et même des récipients en verre ! En résumé, « il existe une confusion temporelle dans ces représentations qui mélangent d’anciens stéréotypes biologiques avec des technologies plus récentes, ce qui témoigne d’une faible correspondance avec les connaissances scientifiques contemporaines sur les Néandertaliens », estiment les chercheurs.

Inquiétude quant aux sources d’entraînement des IA génératives

Pour mieux évaluer ces incohérences, il est nécessaire de comprendre comment fonctionnent les deux IA testées. Toutes les deux « sont des modèles d’apprentissage profond transformeurs qui ont appris à prédire des séquences complexes de données, expliquent les auteurs. Dans le cas de ChatGPT, cela permet de générer un texte cohérent en réponse à une requête soumise par l’utilisateur. Pour DALL-E 3, cette structure de base du transformeur fonctionne en association avec un modèle de diffusion, qui commence par un bruit aléatoire et le supprime progressivement afin de générer une image qui correspond à la requête textuelle. Ce processus itératif est guidé par des modèles appris à partir des données d’entraînement et est conçu pour produire des images à la fois cohérentes et conformes aux types d’images vues pendant l’entraînement. »

Mais quelles sont exactement ces séquences de données et ces images lues et visionnées à l’entraînement? Les chercheurs indiquent que les développeurs ne dévoilent pas les sources d’entraînement des IA qu’ils mettent au point. Certains archéologues pensent qu’il s’agit de Wikipédia, mais cette étude met en évidence que les sources sont bien plus anciennes, et surtout, qu’elles sont presque entièrement indépendantes de la recherche scientifique.

Faut-il que l’IA ait plus largement accès aux sources scientifiques?

Pour délivrer l’IA générative des biais démontrés dans le cadre de cette étude de cas, qui risquent de se propager à grande échelle étant donné l’usage intensif de ces nouveaux outils, les chercheurs pensent qu’il faut faire évoluer la politique en matière d’accès aux données. Autrement dit, ils plaident, au nom de l’accès commun à la connaissance, pour la suppression des restrictions (« paywall » en particulier) pratiquées par les éditeurs scientifiques. « Les pratiques de publication universitaire pourraient finalement nuire à la connaissance publique », affirment-ils. Oui, mais… cela revient quand même à entériner, en le favorisant, le pouvoir de l’IA sur l’accès au savoir. Et serait-elle d’ailleurs plus fiable si elle avait accès à toutes les publications scientifiques dans leur intégralité, y compris les plus modernes? Cela reste à prouver.

D’autre part, pourquoi confier cette tâche à l’IA, là où des professionnels s’en chargent déjà? Chercheurs, journalistes, documentalistes, ils sont nombreux à être experts dans leur domaine et à savoir – et pouvoir – trouver les sources les plus fiables. Les étudiants bénéficient d’un large accès aux revues scientifiques par le biais de leurs bibliothèques universitaires. Quant au grand public, il existe de nombreux outils et de nombreux interlocuteurs à sa disposition pour lui permettre d’accéder au savoir vulgarisé et expert. Alors si l’IA se trompe, n’est-ce pas aussi une bonne nouvelle pour tous ceux qui font encore confiance à l’intelligence humaine?