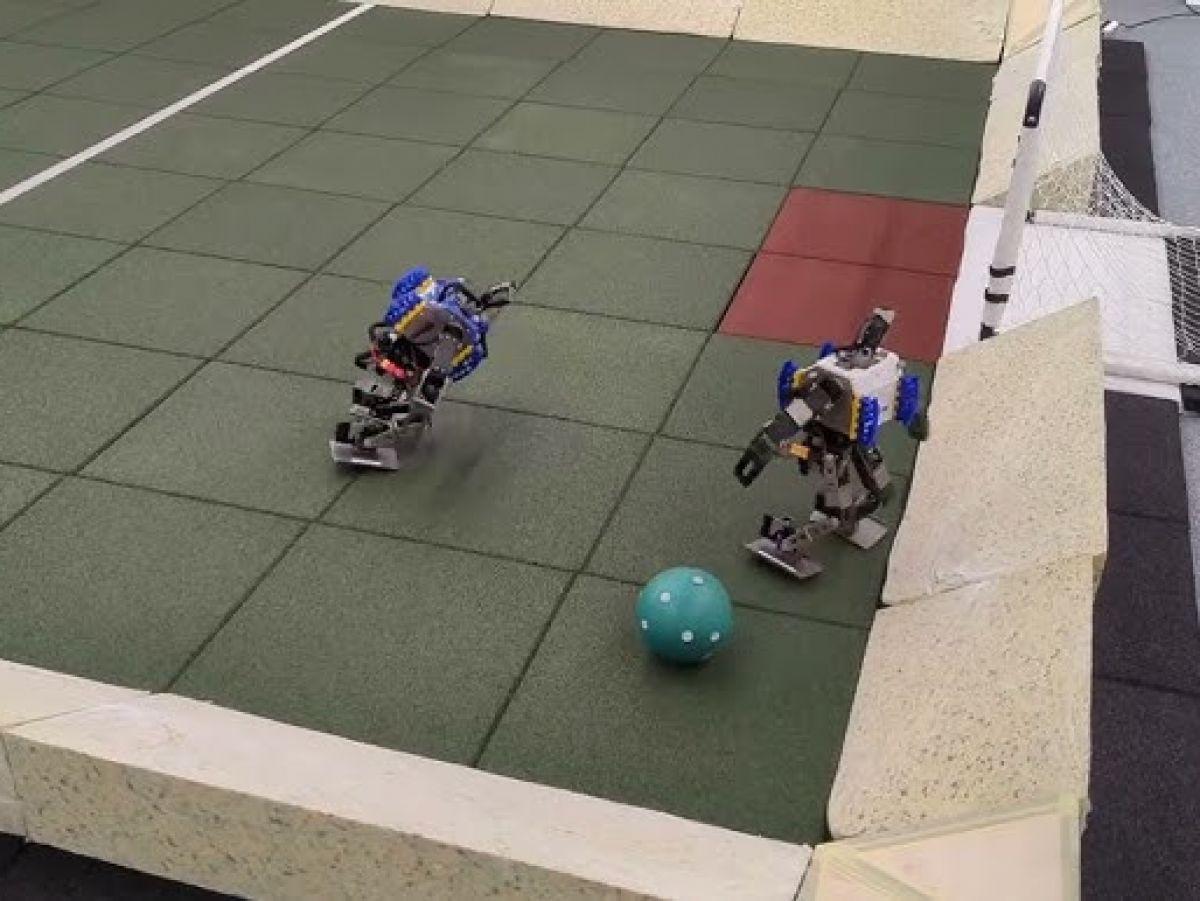

Africa-Press – Senegal. Ces deux footballeurs courent, marchent, contournent l’adversaire, tombent, se relèvent, tirent et marquent des buts. Rien de très original, si ce n’est qu’il s’agit de mini-robots de cinquante et un centimètres de haut et 3,5 kg de la société Robotis, dotés de 20 articulations et parfaitement autonomes.

Les machines ont été entraînées à jouer au football par une équipe de Google Deepmind en utilisant la méthode d’apprentissage automatique dite d’apprentissage par renforcement. Appelé OP3 Soccer, ce projet fait l’objet d’un article dans la revue Science Robotics d’avril 2024.

Au lieu d’utiliser une base de données, les algorithmes appelés à piloter le robot apprennent ce qu’ils convient de faire dans une situation donnée par essai-erreur. Il n’y a aucune instruction préprogrammée, l’algorithme ne sait pas à l’avance ce qu’il faut faire. Il y a donc beaucoup d’erreurs, de décisions hasardeuses, mais chaque geste bien exécuté s’accompagne d’un signal de récompense. Si bien que l’algorithme, peu à peu, avance dans son apprentissage en ne retenant que les actions qui ont été récompensées.

Un algorithme qui tâtonne pendant très longtemps

L’approche a ceci d’intéressant qu’elle fait choisir à l’algorithme des techniques et des mouvements qu’il enregistre comme étant les plus efficaces mais qui peuvent être inattendues voire contre-intuitives. Certains n’auraient jamais été codés par des informaticiens dans les instructions données à un robot préprogrammé. “Un bon exemple réside dans la manière dont le robot se retourne, en pivotant sur le coin d’un pied, et qui aurait été très difficile à coder mais qui s’est avérée plus efficace qu’une approche traditionnelle”, écrivent les auteurs de l’article.

L’apprentissage par renforcement implique cela dit d’y passer énormément de temps. D’abord parce que, contrairement aux humains qui comprennent au bout d’un ou deux essais ce qu’il faut faire, l’algorithme tâtonne pendant très longtemps. Ensuite parce qu’un entrainement ne porte que sur un aspect des actions à apprendre. Se relever, tirer, contourner l’adversaire, le contrer, tout cela nécessite des phases d’apprentissage dédiées.

C’est pourquoi elles se déroulent d’abord en simulation. Les algorithmes destinés plus tard à être embarqués dans les robots animent d’abord deux avatars sur un terrain virtuel, sur écran. Ce qui évite de multiplier les manipulations physiques et les éventuels dommages lorsque les machines chutent (rendez-vous sur la page du projet de Deepmind pour regarder les vidéos de l’entrainement en simulation et situation réelle).

Une caméra dans la tête

Après quoi, l’algorithme est utilisé en situation réelle avec les robots programmables de chez Robotis. Ils sont dotés d’un système de capture de mouvements, avec caméra Logitech en guise de tête et marqueurs infrarouges sur le corps (ainsi que sur la balle).

Le passage de la simulation à l’environnement ne se fait toutefois pas sans heurts. Par exemple, pour une action consistant à se relever et à tirer, il y a but dans 70% des 50 sessions en simulation. En conditions réelles, ce score tombe à 58% pour 50 sessions. Il y a donc perte d’efficacité. “Mais le robot reste capable de se relever, de frapper la balle et de marquer dans la majorité des cas”, soulignent les chercheurs.

De fait, à terme, les performances des robots formés après un apprentissage par renforcement se montrent bien plus performants qu’un robot dont on a programmé les mouvements. Les chercheurs ont en effet mené des tests comparatifs. Les premiers marchent 181% plus vite que les seconds, changent de direction 302% plus vite, prennent 63% moins de temps pour se relever après une chute, frappe le ballon 34% plus vite.

Vers des plus grands robots footballeurs ?

Il reste nombre de limites au projet que soulignent les chercheurs. Ce qui fonctionne bien avec des petits robots n’est peut-être pas transposables à de plus grosses machines. La vision par caméra infrarouge n’est pas toujours adaptée, les repères placés sur la balle sont parfois dans des angles morts et finalement seuls ceux du dessus sont visibles par les caméras. En fait, une dose d’apprentissage sur base de données en complément pourrait aussi améliorer les comportements et les performances des machines, notamment le passage entre environnement simulé et situation réelle.

Pour plus d’informations et d’analyses sur la Senegal, suivez Africa-Press