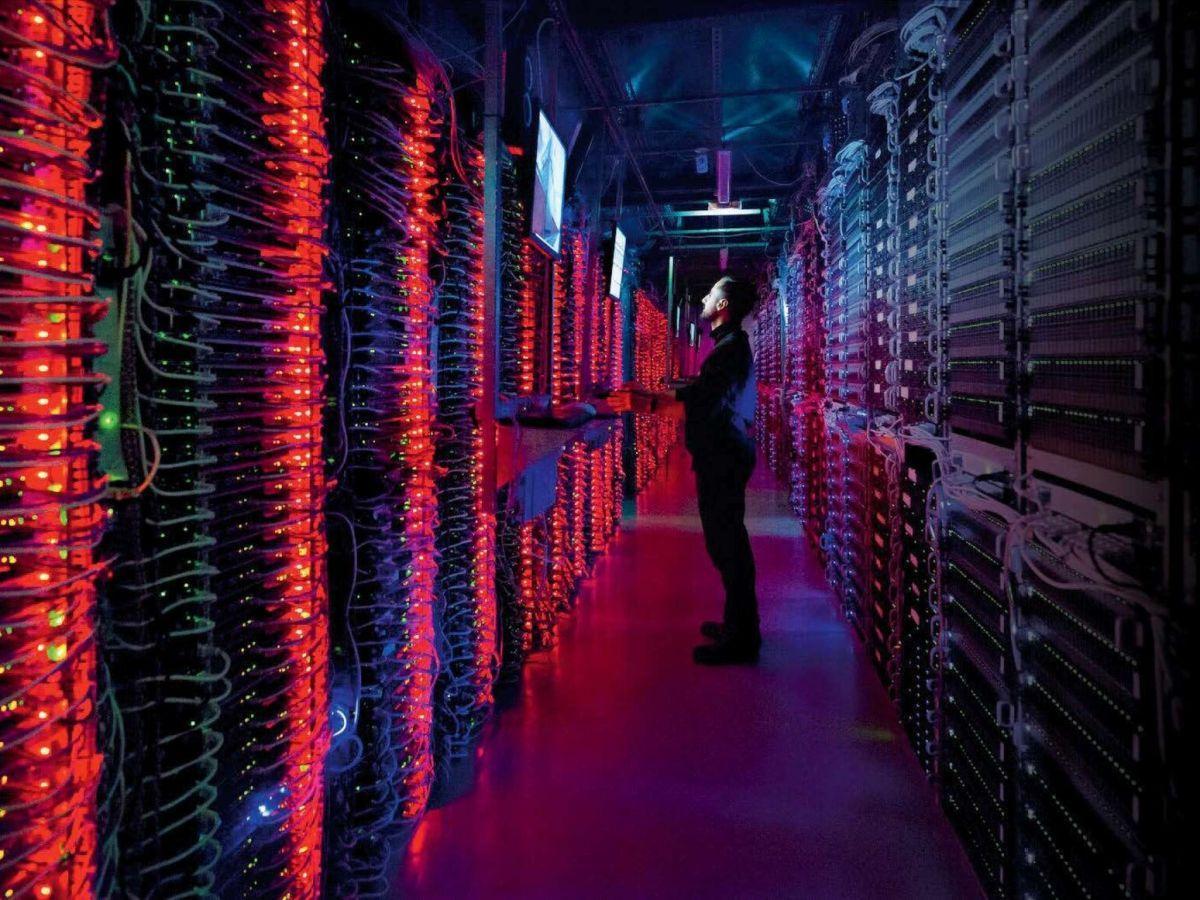

Africa-Press – CentrAfricaine. Environ 2 % de la consommation mondiale d’électricité. Voilà ce que consomment aujourd’hui les centres de données, supports des technologies de l’intelligence artificielle (IA) et des blockchains, selon un rapport de l’Agence internationale de l’énergie (AIE) publié en 2024. Quelle part représente précisément l’IA dans cette estimation ? Il est extrêmement difficile de le savoir.

Notamment parce qu’une fois son apprentissage terminé, une IA est déployée sur plusieurs serveurs installés un peu partout dans le monde. Or ceux-ci sont généralement partagés avec de multiples applications d’analyse, de stockage et de traitement de données. S’il est facile de mesurer la consommation électrique d’un serveur informatique, il est en revanche beaucoup plus compliqué de savoir combien consomme chaque application. Certes, la chose n’est pas impossible, mais elle demande une méthodologie parfois complexe, le déploiement d’outils spécifiques, et donc des frais supplémentaires.

De plus, l’absence de standardisation dans le calcul de la consommation d’une IA complique singulièrement la donne. Certaines estimations incluent l’énergie consommée pour la fabrication des équipements, tandis que d’autres excluent les dépenses liées au refroidissement des serveurs. Certaines ne comptabilisent que l’énergie dépensée lors de l’entraînement de l’IA, tandis que d’autres prennent également en compte son usage lorsqu’elle est déployée.

La phase d’entraînement, particulièrement énergivore

C’est la raison pour laquelle, lorsque l’on cherche à comparer la consommation des IA, il est souvent plus simple de se focaliser uniquement sur la phase d’entraînement. Non seulement parce qu’elle est réalisée dans des serveurs exclusivement réservés à cet usage, mais aussi parce que c’est la plus gourmande en énergie.

Selon une étude chinoise publiée en août dernier dans Nature, entraîner un modèle comme ChatGPT (version 3) nécessite 1287 mégawattheures (MWh) d’électricité, soit l’équivalent de la consommation annuelle de 120 foyers américains. « 90 % de l’énergie consommée durant cette phase provient du mouvement continu des données, entre le lieu de stockage et celui de traitement « , estime Dejan Glavas, directeur de l’institut IA for Sustainability, une structure consacrée à la promotion de la recherche interdisciplinaire sur l’intelligence artificielle.

Or, la précision d’une IA est étroitement liée à la quantité de données qu’on lui a fournies pour s’entraîner. Par exemple, si vous entraînez une IA à identifier des végétaux, il faudra lui fournir des milliards d’images pour qu’elle soit capable de reconnaître correctement chaque plante. Et plus il y en aura, moins le risque d’erreur sera grand.

Une fois que l’IA est « éduquée » et déployée, c’est-à-dire mise en service, elle continue à consommer beaucoup d’énergie pour traiter les requêtes des utilisateurs, mais bien moins que durant sa phase d’entraînement. « Bâtir une IA, c’est un peu comme construire l’infrastructure de transports d’une ville: vous allez dépenser énormément d’énergie pour mettre en place les voies de circulation, les bus, les trams et les métros… Par la suite, la dépense énergétique pour faire fonctionner tout cela demeure mais elle est bien moindre « , explique Dejan Glavas.

Un « moindre » à relativiser toutefois, puisque dans la dernière version de ChatGPT (la quatrième), chaque requête consomme 0,0005 kWh. Pour 10 millions de requêtes quotidiennes – la moyenne de ce que reçoit l’IA -, cela équivaut à une consommation annuelle d’environ 1825 MWh pour GPT-4, soit l’équivalent d’environ 170 foyers américains alimentés en un an.

Et le problème de la consommation de l’IA devient encore plus inextricable si l’on cherche à l’exprimer en termes d’empreinte carbone. Car celle-ci est étroitement liée à la nature de l’électricité consommée pour faire fonctionner l’IA. En moyenne, un kilowattheure produit à partir de charbon génère plus de 820 grammes d’équivalent CO2, contre 24 g pour l’hydroélectricité et 12 g pour le nucléaire, d’après les données de 2014 du Groupe d’experts intergouvernemental sur l’évolution du climat (Giec). L’empreinte carbone dépend donc de l’endroit où est situé le serveur qui va traiter les requêtes, c’est-à-dire des sources d’énergie locales utilisées pour alimenter les centres de données.

De façon paradoxale, parmi la kyrielle de domaines d’application de l’IA, est avancé celui de… la réduction de la consommation énergétique. Google, par exemple, a utilisé l’IA pour réduire de 40 % l’énergie nécessaire au refroidissement de ses centres de données en prévoyant précisément les pics d’activité. De son côté, le transporteur DHL explique que le déploiement de l’IA dans le cadre de la logistique du dernier kilomètre lui a permis d’optimiser le chargement de ses camions et de ses itinéraires de livraison, réduisant ainsi la consommation de carburant. Dans un autre registre, l’exploitation de l’IA Deepmind (Google) a permis d’augmenter de 20 % la valeur de l’électricité produite par un champ d’éoliennes aux États-Unis en se montrant capable d’anticiper les vents (et donc la production énergétique) avec une journée d’avance. Augmenter ainsi la rentabilité des énergies renouvelables contribue indirectement à leur déploiement.

Une étude conduite par le cabinet de conseils Boston Consulting Group sur l’impact de l’IA et son potentiel de réduction des émissions de carbone estime les émissions mondiales de gaz à effet de serre (GES) à environ 53 gigatonnes (Gt) en 2021, date de publication du rapport.

« L’utilisation de l’IA peut permettre de réduire les émissions globales de 5 à 10 %, soit l’équivalent de 2,6 à 5,3 Gt d’équivalent CO2 si elle était appliquée à toutes les émissions », avance l’étude. Ce qui est loin d’être négligeable, mais pas suffisant pour réduire les émissions de moitié d’ici à 2030, objectif nécessaire pour contenir le réchauffement climatique sous les 1,5 °C, défini durant l’accord de Paris de 2016.

Comment réduire son empreinte énergétique ?

PRIVILÉGIER LES MODÈLES SPÉCIALISÉS: Une requête sur Google consomme dix fois moins d’énergie que sur ChatGPT. Si une réponse simple suffit, préférer le moteur de recherche. De même, pas besoin de passer par une IA généraliste pour traduire un texte. DeepL Translator ou Google Translate donneront des résultats tout aussi satisfaisants.

UTILISER DES IA « LÉGÈRES »: Pour un usage généraliste, il est préférable d’utiliser des modèles comme Mistral, conçus pour une consommation optimisée.

PRIVILÉGIER LES IMAGES EXISTANTES: Générer une image au moyen d’une intelligence artificielle consomme 60 fois plus d’énergie qu’un texte. Pour illustrer ses productions, privilégier les images déjà existantes.

La course à la précision devrait atteindre ses limites planétaires

De plus, la consommation énergétique liée au développement de l’IA est loin d’être sur une pente descendante. Tout d’abord, parce que certains concepteurs d’IA se livrent à une course pour développer les modèles les plus précis, et donc les plus gourmands en ressources. Ensuite, parce que les IA sont de plus en plus nombreuses. Selon le rapport AI Index de l’université Stanford (États-Unis), rien qu’en 2023, pas moins de 87 nouveaux modèles d’apprentissage machine sont nés soit du secteur privé, soit de la recherche académique, ou d’une collaboration entre les deux.

D’après l’Agence internationale de l’énergie, cette consommation liée à l’IA, estimée en 2022 à environ 460 térawattheures (TWh), devrait plus que doubler d’ici à 2026, en franchissant la barre des 1000 TWh, soit l’équivalent de la consommation électrique annuelle du Japon ! À ce rythme, il est peu probable que les gains énergétiques que pourrait générer l’IA parviennent à contrebalancer les coûts de son développement et de son utilisation. « Mais cette course sans fin à la précision va finir par se heurter à des limites planétaires, non seulement au niveau énergétique, mais aussi des données disponibles, conclut Dejan Glavas. Aujourd’hui, on a aspiré et traité l’équivalent d’Internet pour entraîner des modèles comme GPT-4, et on manque désormais d’écrits humains ! »

Des installations et matériaux gourmands en eau

Les centres de données nécessaires au développement de l’intelligence artificielle sont de grands consommateurs d’eau. Selon une étude conduite par l’université de Californie à Riverside (États-Unis), publiée sur le site arXiv (et donc non validée par les pairs), Google, Microsoft et Meta ont utilisé en 2022 environ 2,2 milliards de mètres cubes d’eau pour refroidir leurs installations. Selon l’étude, cette consommation pourrait augmenter d’ici à 2027 et atteindre 4,2 à 6,6 milliards de mètres cubes, soit l’équivalent de la moitié des besoins annuels du Royaume-Uni.

Cette dépense est liée non seulement au refroidissement des serveurs par des circuits d’eau (watercooling), mais aussi à la consommation d’eau pour fabriquer les semi-conducteurs (cartes graphiques, processeurs…) qui constituent l’infrastructure de l’IA. D’après les travaux d’une équipe chinoise, publiés en 2023, qui a passé en revue la consommation d’eau de 24 gros producteurs de semi-conducteurs (tels que Samsung, Intel ou Seagate), celle-ci était en 2021 de 751 millions de mètres cubes, soit l’équivalent de la consommation annuelle d’environ 13,7 millions de Français.

Pour plus d’informations et d’analyses sur la CentrAfricaine, suivez Africa-Press