Africa-Press – Burkina Faso. Une clé USB « 32 Go » ne fait pas 32 gigaoctets. Ce qui est annoncé, c’est la capacité nette. Sa capacité brute est plus grande. Cela permet de faire de la correction d’erreurs. Ordinateurs, téléphones… Partout, l’information est partiellement redondante de manière à pouvoir corriger un bit défaillant. Il en va de même pour un ordinateur quantique, mais dans des proportions incomparables.

« Aujourd’hui, nos ordinateurs quantiques font en moyenne une erreur toutes les mille opérations ; dans nos téléphones, c’est une erreur tous les un million de milliards d’opérations « , illustre Nicolas Delfosse, à la tête de l’équipe de recherche sur la correction d’erreurs d’IonQ. Et le constat ne changera pas drastiquement. Le manque de fiabilité est inhérent aux qubits.

Dans un ordinateur quantique, les fautes peuvent en effet arriver à tout moment. C’est ce qu’on appelle la décohérence, quand un qubit perd son état quantique. Il n’est alors plus à la fois 1 et 0 en même temps, il devient, comme un bit classique, soit 1, soit 0, ce qui fausse le calcul. Plus le temps passe, plus il y a de chances que cela arrive. Puisqu’elles sont inéluctables, que faire de ces erreurs ?

Les idéalistes rêvent d’une machine qui corrige ses fautes au fil de l’eau et pourrait tourner théoriquement à l’infini: l’ordinateur tolérant aux fautes (le large scale quantum, ou LSQ). Les pragmatiques croient, eux, en des méthodes qui atténuent les effets des erreurs sur le résultat final, de sorte qu’un ordinateur quantique « bruité » (c’est-à-dire commettant des erreurs) pourrait sortir des résultats intéressants quand même. Ce type de machine est appelé NISQ (noisy intermediate scale quantum). Ici, les erreurs ne sont plus corrigées, mais « mitigées ».

La mitigation d’erreurs, une transition vers la correction

Une méthode de mitigation d’erreurs très prisée s’appelle « l’extrapolation à zéro bruit ». « On fait un premier calcul quantique avec le moins d’erreurs possible, explique Thomas Ayral, ingénieur de recherche chez Eviden (groupe Atos). Ensuite, on augmente artificiellement le bruit, c’est-à-dire la quantité d’erreurs de l’ordinateur quantique et on refait le même calcul. On réitère cette manipulation plusieurs fois, en augmentant toujours un peu plus le bruit, et on obtient une courbe avec tous les résultats. Enfin, on extrapole cette courbe vers la partie que nous n’avons pas, celle qui tend vers la limite zéro bruit (sans erreur), et on espère trouver ainsi un résultat quasi exact. »

Aujourd’hui, toutes les entreprises disposant d’un ordinateur quantique utilisent la mitigation. Mais cette solution n’est pas toujours rigoureuse mathématiquement. « C’est une sorte de bricolage, affirme Thomas Ayral. Elle peut fonctionner, mais nous n’avons pas de garanties, contrairement à la correction d’erreurs où il y a une base théorique solide. »

Au fil des progrès, les ordinateurs quantiques sont capables de faire des calculs avec un nombre d’opérations de plus en plus important. Or « la mitigation d’erreurs a un coût qui augmente de façon exponentielle avec la taille du circuit [nombre de portes logiques, ndlr] qu’on fait tourner « , précise Nicolas Delfosse. Autrement dit, un jour ou l’autre, le temps de calcul pour mitiger les erreurs explosera.

En attendant, les recherches dans ce domaine se poursuivent. « On voit beaucoup la mitigation comme une transition vers la correction d’erreurs. C’est probable, mais l’ordinateur tolérant aux fautes est encore loin. En attendant, ça a du sens de voir jusqu’où on peut aller en mitigeant les erreurs « , remarque Valentin Savin, chercheur au CEA-Leti de Grenoble.

Malgré tout, l’ordinateur tolérant aux fautes grâce à la correction d’erreurs reste le graal de l’ordinateur quantique. « Contrairement à ce qu’on peut faire avec la mitigation, nous avons des preuves théoriques que les ordinateurs tolérants aux fautes résolvent certains problèmes plus rapidement qu’un ordinateur classique « , détaille Christophe Vuillot, chargé de recherche à l’Institut national de recherche en sciences et technologies du numérique (Inria) de Nancy.

Son principe ressemble un peu à celui d’une partie de Monopoly, où les joueurs cherchent à combiner des maisons pour obtenir des hôtels, car ils sont plus rentables. Dans un ordinateur quantique, on combine des qubits pour former une entité plus robuste: le qubit logique. Mais il y a plusieurs manières de combiner les qubits. Aussi faut-il déterminer le schéma parfait pour qu’un minimum de qubits permettent de corriger un maximum d’erreurs.

Des codes moins gourmands en qubits

Un code à l’architecture assez simple a longtemps dominé les débats: le code de surface. Mais avec lui, il faut environ mille qubits pour faire un qubit logique suffisamment fiable, ce qui est trop coûteux. Les meilleures machines atteignent à peine la centaine de qubits aujourd’hui. « Il y a une dizaine d’années, il a été prouvé de manière théorique qu’une famille de codes – les codes LDPC (low density parity check) – était optimale « , assure Nicolas Delfosse.

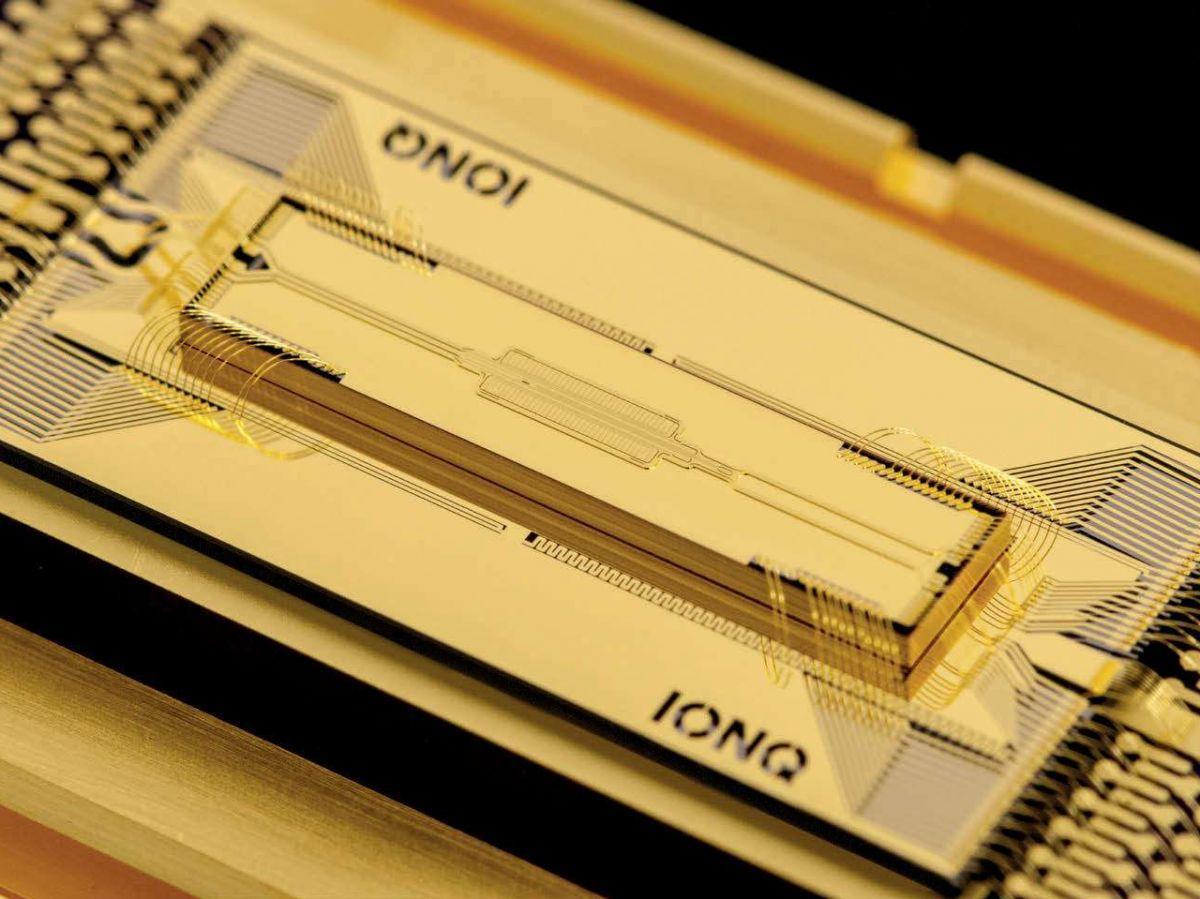

Ces codes sont moins gourmands en qubits, mais leur mise en place nécessite que des qubits éloignés interagissent – et non des qubits voisins comme avec les codes de surface. La technologie des ordinateurs quantiques d’IBM ou de Google, les supraconducteurs, rend quasi impossible ces liens entre qubits éloignés. En revanche, de plus en plus de technologies le permettent. C’est le cas notamment des puces quantiques à ions piégés, privilégiées par IonQ, ou de celles aux atomes neutres prisées par la jeune pousse française Pasqal.

Dans la course entre différentes technologies de qubits, les impératifs dictés par les codes correcteurs d’erreurs pourraient bien constituer le juge de paix entre toutes.

Pour plus d’informations et d’analyses sur la Burkina Faso, suivez Africa-Press