Africa-Press – Benin. Des sous-titres pour les films qu’on se fait dans la tête. Les neurotechnologies parviennent de mieux en mieux à « lire » nos pensées, décodant ce qu’un individu veut dire, et même ce qu’il pense, mais ne veut pas forcément dire. Les avancées de ces dispositifs sont telles qu’ils ne se contentent plus de décrypter les pensées verbales: quelques équipes ont déjà montré qu’il est possible aussi de « voir » les pensées visuelles, c’est-à-dire de deviner l’image qu’une personne est en train de regarder.

Une nouvelle étude va plus loin, décrivant le contenu de vidéos qu’on regarde juste en analysant l’activité cérébrale. Cette nouvelle avancée, présentée le 5 novembre 2025 dans la revue Science Advances par un chercheur de l’entreprise japonaise de communications NTT, ne s’intéresse pas aux pensées verbales, mais aux pensées visuelles, et pourrait ainsi permettre de décoder la pensée des sujets qui ne maitrisent pas le langage, comme les bébés ou les animaux.

Une IA pour décrire les images qu’on observe

Ce décodage repose en grande partie sur une intelligence artificielle (IA) conçue pour décrire une séquence d’images, générant des textes comme ceux utilisés pour permettre aux personnes mal voyantes de profiter d’un film. Ce modèle de langage est entraîné pour ajouter progressivement des mots décrivant les éléments d’une image et la manière dont ils interagissent. Cette méthode, nommée modélisation de langage masqué (ou « masked language modeling », MLM), prédit les mots qui manquent à une phrase, ajoutant pas à pas toutes les descriptions nécessaires pour avoir une bonne idée de ce qui passe à l’écran. Puis, ces descriptions sont traduites en traits sémantiques: par exemple, si on voit une chanteuse à l’image, les traits sémantiques pourraient être « femme », « artiste », « chanter », etc.

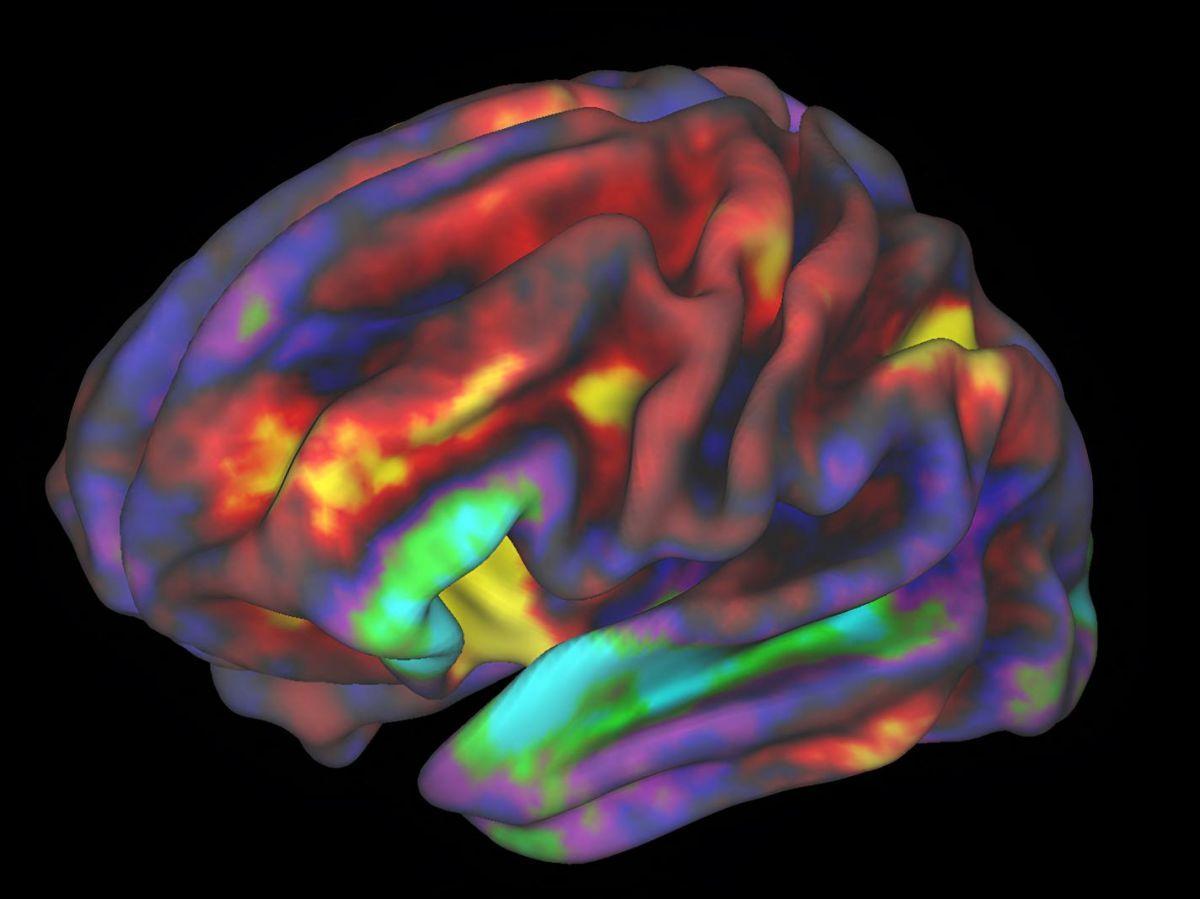

En parallèle, l’utilisateur regarde cette même séquence d’images et l’activité de son cerveau est enregistrée par IRM fonctionnelle (IRMf), qui permet d’analyser le flux sanguin dans le cerveau et ainsi savoir quelles aires sont activées en temps réel. Le but étant d’entrainer le système pour associer cette activité cérébrale aux traits sémantiques liés aux images observées. Pour ensuite pouvoir inférer les images que l’utilisateur observe ou imagine à partir des traits sémantiques associés à son activité cérébrale.

« Lire » le cerveau pour « voir » l’imagination

Cette méthode a été testée chez six participants, comparant les descriptions générées à partir de leur activité cérébrale lorsqu’ils regardaient une vidéo avec celles que l’IA produit directement à partir de la même vidéo. Le but étant de savoir si ces descriptions extraites directement de la pensée des utilisateurs permettaient de deviner quelle vidéo ils regardaient (sur un total de 100 vidéos).

Le taux de réussite pour certains participants était d’environ 40 %, sachant que le taux de réussite dû uniquement au hasard (c’est-à-dire si la méthode ne marchait pas) était calculé à seulement 1 %. Autrement dit, la lecture de l’activité cérébrale parvenait bien à extraire partiellement des descriptions qui correspondaient bien à la vidéo regardée, même si l’efficacité peut être encore améliorée. Et cela fonctionnait même lorsque le participant ne regardait pas directement la vidéo, mais s’en souvenait, montrant que cette technique pourrait permettre aussi de deviner ce que l’on imagine, pas seulement ce que l’on voit.

Des prédictions qui ne dépendent pas du langage

On pourrait imaginer que la génération de ces descriptions dans l’esprit utilise le langage et que le cerveau pourrait traduire ce qu’il voit en mots pour mieux le comprendre. Et donc que cette méthode pourrait être en train de capter simplement ces mots que le cerveau se dit en regardant le film. Mais ce n’est pas le cas, ces descriptions générées par la pensée étaient bien dues aux pensées visuelles et non aux pensées verbales.

Deux expériences permettent de l’affirmer: d’abord, pendant la période de préparation, lorsque les participants sont devant l’écran et se préparent à regarder la vidéo, ils pouvaient lire le texte de description générée en amont par l’IA décrivant la vidéo. Pourtant, l’activité cérébrale enregistrée à ce moment produisait des descriptions beaucoup moins précises que lorsqu’ils regardaient la vidéo. Deuxièmement, l’analyse des seules régions cérébrales dédiées au langage ne produisait pas de descriptions aussi détaillées que l’analyse de l’ensemble du cerveau, y compris des régions cruciales pour le traitement des informations visuelles. Autrement dit, ce sont principalement les images recréées dans l’esprit qui permettaient de produire de bonnes descriptions.

Cette capacité à « voir » ce que le cerveau voit pourrait être utilisée notamment pour des personnes qui ne maitrisent pas le langage, soit à cause d’un accident ou une maladie qui affecte la région nécessaire au traitement de cette information, soit parce que l’individu ne parle pas la langue utilisée par la méthode (l’anglais). L’article de recherche va plus loin et propose même que cette méthode pourrait être utilisée pour décoder la pensée de bébés ou des animaux, en contournant les barrières de langage.

Cependant, l’auteur prévient aussi que cette méthode est seulement interprétative: elle ne recrée pas une reconstruction littérale de la pensée, mais l’interprète en fonction du modèle de langage utilisé (et de ses biais). Ainsi, la pensée est filtrée en quelque sorte, pour qu’elle puisse être comprise par l’IA. Pour finir, il soulève une question essentielle: quel est le risque éthique de pouvoir accéder à la pensée avec de simples IRMf, utilisés régulièrement en clinique et en recherche? Et rappelle l’urgence de réguler ces neurotechnologies afin de sauvegarder la vie privée des utilisateurs, pour s’assurer que ces films « qu’on se fait dans la tête » n’en sortent pas, sauf si on le souhaite vraiment.