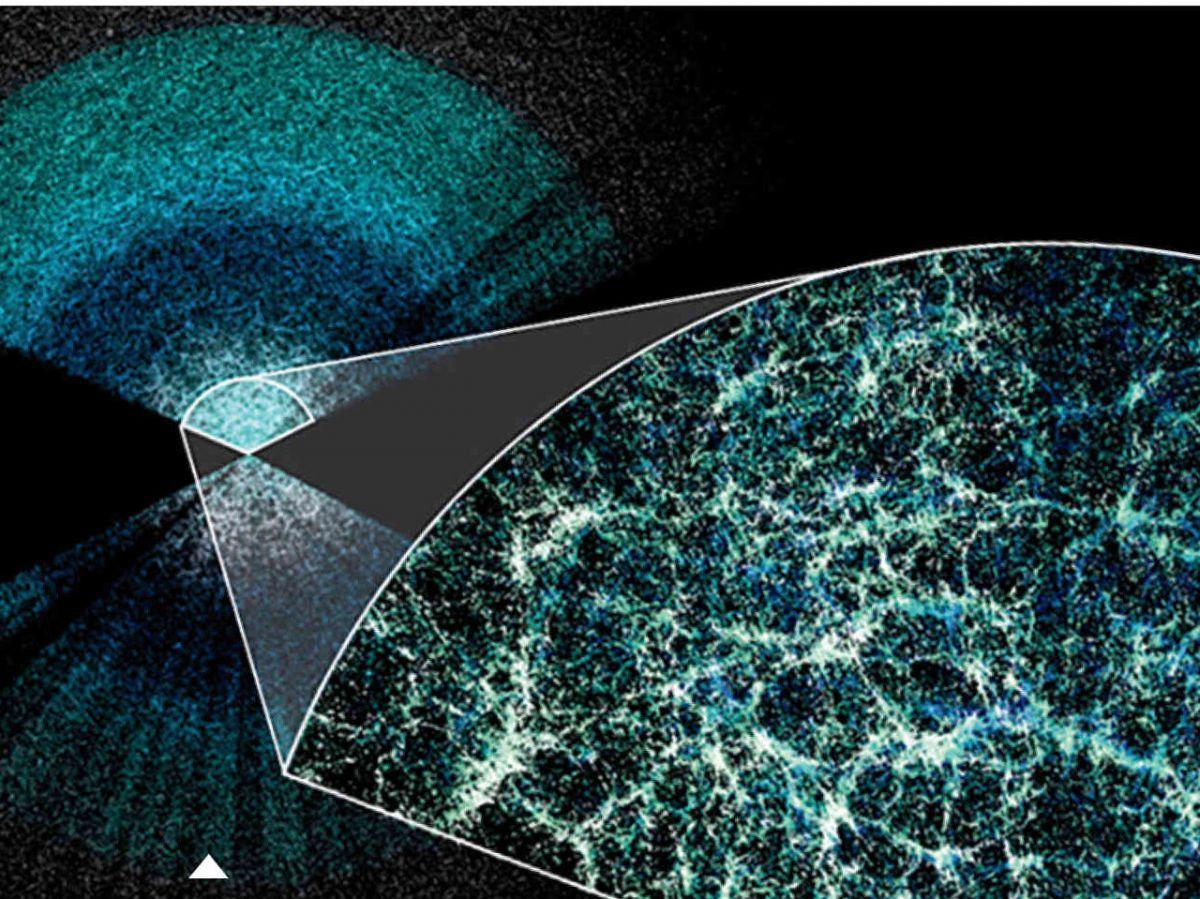

Africa-Press – Côte d’Ivoire. De l’infiniment petit à l’infiniment grand, l’IA s’impose peu à peu comme un outil précieux pour explorer les mystères de l’Univers comme ceux de la matière. Ainsi, le programme DESI (Dark Energy Spectroscopic Instrument) consiste à cartographier 40 millions de galaxies et de quasars (des noyaux de galaxies très brillants) afin de reconstruire l’histoire de l’expansion de l’Univers sur près de 11 milliards d’années. Les relevés sont réalisés à partir d’un instrument installé à l’observatoire de Kitt Peak, en Arizona (États-Unis), capable de saisir 5000 cibles d’un coup. Mais encore faut-il les choisir.

« Il a fallu sélectionner des galaxies couvrant l’ensemble de la tranche d’Univers qui nous intéresse, explique Nathalie Palanque-Delabrouille, cosmologiste au CEA et porte-parole de la collaboration DESI. Nous avons réalisé une optimisation entre les galaxies proches, les plus lointaines, les quasars les plus brillants… Pour faire ce tri considérable, nous avons recouru à des algorithmes d’intelligence artificielle. Cela a permis, par exemple, d’améliorer de 20 à 30 % la qualité de sélection des quasars. »

L’intelligence artificielle est également employée afin de corriger la carte de l’Univers des imperfections dans les images utilisées pour la sélection des cibles. « Pour interpréter les données et reconstituer l’organisation des galaxies à très grande échelle, nous avons besoin d’une imagerie de grande qualité. Les algorithmes de type machine learning apportent une meilleure correction des inhomogénéités photométriques [dues notamment aux perturbations atmosphériques] que les approches traditionnelles. »

Une utilité dans l’amélioration du traitement de l’image

Un autre programme phare de l’astronomie, le télescope spatial James Webb ( JWST), utilise aussi l’IA, mais avec modération, résume Hakim Atek, astronome à l’Institut d’astrophysique de Paris, spécialiste de l’histoire des galaxies et très impliqué au sein du JWST. « C’est un outil qui permet d’accélérer certaines analyses, comme la reconnaissance des formes de galaxies, ou d’améliorer le traitement de l’image, en faisant ressortir une galaxie du bruit de fond ambiant qui la masque. Mais l’IA ne s’impose pas tant que cela, car le volume de données généré par les instruments du JWST reste à taille humaine. » Le chercheur souligne toutefois que « ce n’est pas la même chose pour d’autres instruments comme le radiotélescope SKA [installé en Australie, il traque aussi l’origine des étoiles et des galaxies, mais dans une autre gamme de fréquences que le JWST], ou Euclid [télescope spatial spécialisé dans l’étude de la matière noire et de l’énergie noire] , qui en génèrent beaucoup plus. »

En physique des particules, l’usage de l’IA est plus systématique, et prend une place de plus en plus importante, comme l’explique Simon Akar, physicien des particules à l’Université Clermont Auvergne et membre de l’expérience LHCb au Cern, à Genève (Suisse). « Le LHC [collisionneur de particules du Cern à la frontière franco-suisse], c’est 40 millions de croisements de faisceaux de protons par seconde. Chaque rencontre peut engendrer des dizaines de collisions protons/ protons, d’où jailliront des flopées de particules. Cela crée plusieurs centaines de téraoctets de données par seconde [l’équivalent de 20.000 films en HD]. » Le flux est tel qu’il est impossible de tout garder et une sélection drastique des événements à enregistrer avant analyse est nécessaire. « L’IA, qui excelle dans la catégorisation d’événements, permet une amélioration significative des performances de sélection ».

Les « événements intéressants » sont tous ceux susceptibles de révéler l’existence d’une « nouvelle physique »: des interactions ou bien des particules encore inconnues, prenant ainsi en défaut le modèle standard de la physique des particules.

Débusquer des événements à partir d’hypothèses fournies à l’IA

Les scientifiques utilisent l’IA pour débusquer des événements précis, à partir d’hypothèses qu’ils auront faites et fournies à l’IA. Toutefois, le développement de cet usage se heurte à l’opacité des modèles, particulièrement des réseaux de neurones, qui ne fournissent pas d’explications claires sur les critères qu’ils utilisent. « Cela pose des problèmes d’interprétabilité, résume Simon Akar. On ne sait pas comment l’IA ‘travaille’, quelle fonction elle construit et utilise pour parvenir à un résultat. Il est difficile, dans ces conditions, de calculer des incertitudes, et donc de valider le résultat… » Et quelle est la faculté de l’IA à réaliser une authentique découverte que les physiciens n’auraient pas anticipée ?

« Il se développe désormais des algorithmes d’apprentissage non supervisé qui peuvent identifier des signaux exotiques ou des anomalies dans les données, constate Simon Akar. Mais ces outils servent surtout à pointer des événements inhabituels à examiner, pas à conclure sur une découverte, qui reste l’apanage des chercheurs. »

Une prudence que partage François Vannucci, physicien des particules émérite et auteur de nombreux ouvrages de vulgarisation (dernier paru: « La Promesse du hasard », éd. Odile Jacob). Selon lui, l’IA introduit une forme de révolution conceptuelle en physique. « Depuis Galilée, la méthode scientifique consiste à observer les phénomènes, conceptualiser une loi et vérifier ensuite qu’elle est en accord avec les mesures. Avec l’IA, on cherche toujours à décrire l’évolution d’un système, mais de manière probabiliste, sans comprendre ce qu’il y a derrière. » Il doute ainsi qu’elle débouche un jour sur de grandes découvertes. « Pour cela, l’IA manque de ce que le philosophe Pascal appelait l’esprit de finesse: l’inventivité, l’imagination, l’intuition. » Conquérir cet « esprit de finesse », voilà donc le prochain défi de l’intelligence artificielle…

Pour plus d’informations et d’analyses sur la Côte d’Ivoire, suivez Africa-Press